Wan-Hua Her und Aenne Knierim

Abstract

Dieser Beitrag ist Teil einer Reihe von Beiträgen, die Forschungsprojekte aus den Jahren 2018-2020 im Bereich Digital Humanities vorstellen. Die hier im Themenblock „Sentimentanalyse in Dramen“ zusammengefasste Forschung beleuchtet diese Methodik aus der Perspektive der Multimodalität, der empirischen Annotation und der Zusammenarbeit mit Semi-Expert*innen.

Die hier vorgestellten Forschungsbeiträge des Lehrstuhls sind:

- Sentiment Annotation of Historic German Plays: An Empirical Study on Annotation Behavior

- An Evaluation of Lexicon-based Sentiment Analysis Techniques for the Plays of Gotthold Ephraim Lessing

- „Kann man denn auch nicht lachend sehr ernsthaft sein?“ – Zum Einsatz von Sentiment Analyse-Verfahren für die quantitative Untersuchung von Lessings Dramen

- Sentiment Annotation for Lessing’s Plays: Towards a Language Resource for Sentiment Analysis on German Literary Texts

- Toward Multimodal Sentiment Analysis of Historic Plays: A Case Study with Text and Audio for Lessing’s Emilia Galotti

1. Empirische Annotationsstudie und Evaluation der automatisierten Sentimentanalyse auf Lessings Dramen

Im Beitrag „Sentiment Annotation of Historic German Plays: An Empirical Study on Annotation Behavior“ präsentieren Thomas Schmidt (Mitarbeiter des Lehrstuhls für Medieninformatik), Manuel Burghardt (Mitarbeiter der Computational Humanities Group an der Universität Leipzig) und Katrin Dennerlein (Mitarbeiterin des Instituts für deutsche Philologie an der Universität Würzburg) 2018 auf dem „Workshop on Annotation in Digital Humanities“ Forschungsergebnisse und eine Evaluation von computergestützten Verfahren der Sentimentanalyse von deutschen Dramen aus dem 18. Jahrhundert.

In den letzten Jahren wird Sentimentanalyse häufig für digitale textuelle Inhalten, wie z. B. Kommentare auf Social Media oder Foren, verwendet, um die ausgedrückte Stimmung bzw. Emotion zu analysieren. Des Weiteren werden viele linguistische Datensätze mithilfe von „sentiment bearing words (SBEs)“ erstellt. Diese werden als Lexika zur Erarbeitung von Vorhersagen herangezogen. Der Einsatz von Sentimentanalyse im Bereich der Literaturwissenschaft – vor allem bei den historischen Literaturwerken – ist aber aufgrund des Mangels an ausreichenden Annotationsdatensätzen und der Uneinigkeiten unter den Annotierenden besonders schwierig.

Um die genannten Schwierigkeiten zu bewältigen und einen genügend großen Datensatz für automatisierte Sentiment-Klassifikation zu erzeugen, wurden sechs Kommentator*innen für die Annotationsaufgabe auf ausgewählten Dramen von Lessing rekrutiert. Darunter ist eine Annotatorin in deutscher Philologie promoviert und habilitiert und die anderen (4 weiblich, 1 männlich) haben keine fachliche Expertise.

Es handelt sich dabei um ein Korpus von 12 Dramen und 8 224 Repliken. Die Stichprobe für die Annotationsaufgabe enthält 200 Repliken, die ungefähr 2% des gesamten Korpus ausmachen. Zusätzlich zu den 200 Repliken erhält jede Annotierende drei Schemata für die Annotation: differenzierte Polarität (differentiated polarity), binäre Polarität und 8 Emotionskategorien.

Bei den differenzierten und binären Polaritäten wurden die Annotierenden gefragt, eine Entscheidung für die am besten geeignete Sentimentskategorie zu treffen und bei der Emotionsklassifikation alle vorkommende Emotionen in der Replik zu markieren. Die Beteiligung an einer Umfrage wird nach den Annotationsaufgaben aufgefordert. Von der Schwierigkeit der Repliken über die Zuversicht mit eigenen Annotationen bis zum Zeitaufwand mit den Aufgaben beschreiben die Annotierenden ihre Probleme und allgemeine Eindrücke.

Die Ergebnisse deuten auf eine insgesamt ähnliche Verteilung der Sentiment-Kklassifkation hin, vor allem da etwa eine Hälfte der Annotationen sowohl von den Nicht-Expert*innen als auch von der Expertin negativ markiert wird. Der Unterschied dabei ist jedoch, dass die Expertin die gemischte Annotation „Mixed“ nur selten verwendet (Expertin: 3%, Nicht-Expert*innen: 23%). Bei den Emotionsannotationen sind „Anticipation“ (30,6%) und „Anger“ (21,1%) die am häufigsten vorkommenden Kategorien und „Disgust“ (3,9%) die am seltensten erschienene Kategorie.

Zur Analyse der Übereinstimmung der Annotationen unter den Kommentierenden verwenden Schmidt et al. (2018a) Krippendorff’s α und den durchschnittlichen Anteil der Übereinstimmungen (average percentage of agreement, APA) als Metriken.

Laut Krippendorff’s α und APA sind die Anteile der Übereinstimmungen von differenzierten Polaritätsannotationen sehr niedrig. Allerdings steigt der Grad der Übereinstimmung bei der binären Polaritätsklassifikation.

Der Medianwert von 6 zeigt, dass die Annotation von den Nicht-Expert*innen als sehr anspruchsvoll und herausfordernd empfunden wurde. Die Expertin hingegen bewertet die Schwierigkeit der Aufgaben als leicht bzw. mittelschwer. Unter den Problemen wurden z.B. archaische Sprache und komplexe Sätze, Einordnung inhaltlicher Zusammenhänge sowie Interpretation von Ironie und Sarkasmus berichtet.

Schmidt und Burghardt (2018) erweiterten im Forschungsbeitrag „An Evaluation of Lexicon-based Sentiment Analysis Techniques for the Plays of Gotthold Ephraim Lessing“ die Untersuchung automatisierter Sentimentanalyse auf Lessings Dramen. Um herauszufinden, was für Parameter die Ergebnisse beeinflussen können, wurden verschiedene Variablen evaluiert.

Linguistische Ressourcen wie z.B. dichotome und kontinuierliche Sentiment-Lexika und Stoppwortlisten werden jeweils miteinander verglichen. Es wird ebenfalls systematisch getestet, ob die Einbeziehung von sprachlichen Varianten, die Beachtung von Groß- und Kleinschreibung oder die Lemmatisierung von Wörter eine Rolle bei der Genauigkeit der Vorhersage spielen. Insgesamt werden etwa 400 Konfigurationen exploriert.

Das SentiWS-Lexikon erbringt insgesamt die beste Leistung. Die Erweiterung mit historischen linguistischen Varianten führt bei allen Lexika zu den stärksten Leistungssteigerungen. Die Verwendung von Stoppwortlisten wird generell empfohlen, wenn Stoppwörter in den Sentiment-Lexika vorhanden sind. Bei der Lemmatisierung erreichen beide evaluierte Lemmatisierer fast gleich gute Ergebnisse, aber beide zeigen ähnliche Probleme mit historischer Sprache.

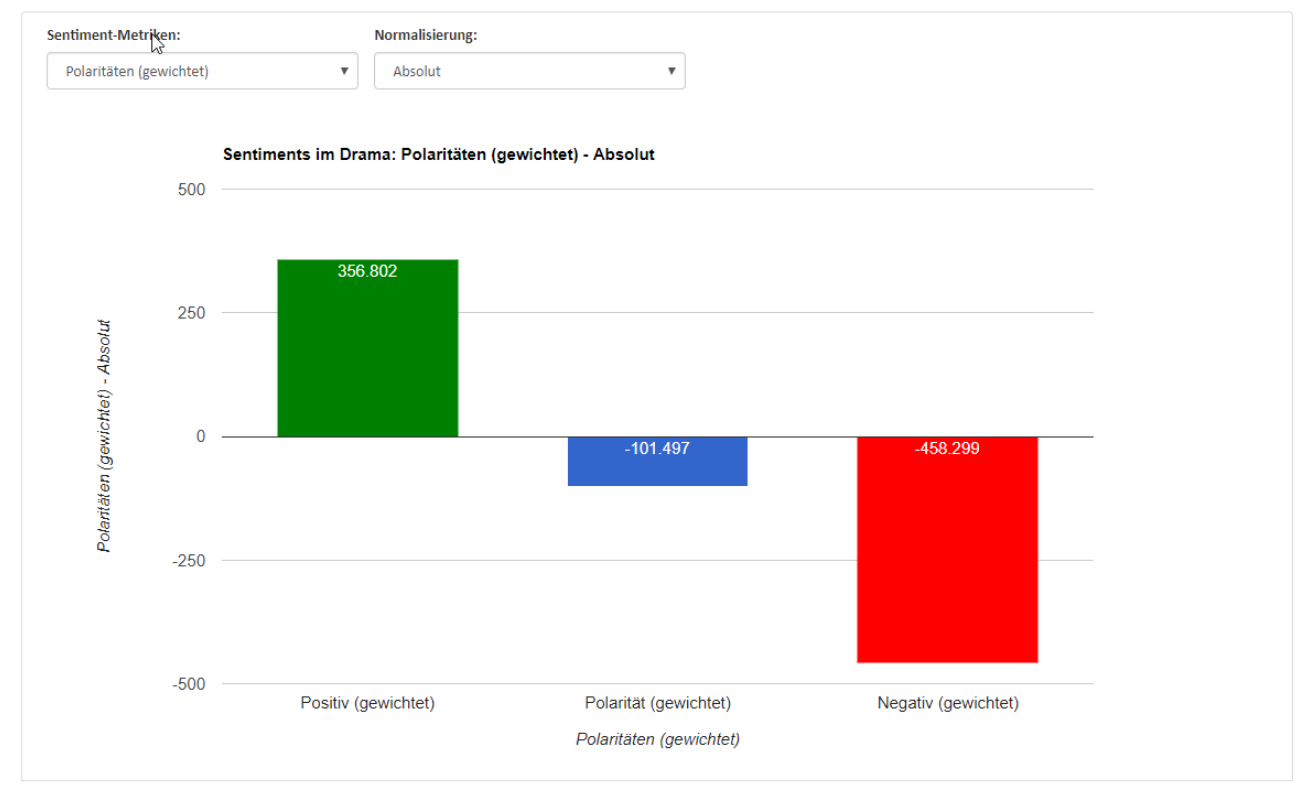

Auf Basis des besten Sentimentanalyse-Ansatzes wurde ein Web-Tool entwickelt. Dieses bietet interaktive Visualisierungen der Sentiment-Verteilungen und -Verläufe für alle berechneten Ebenen. Neben der Integration von SentiWS-Metriken und NRC-Emotionskategorien kann man erste Fallstudien auf Dramen-, Akt-, Szenen-, Repliken- und Sprecherbeziehungsebene durchführen.

Im Paper „Kann man denn auch nicht lachend sehr ernsthaft sein? – Zum Einsatz von Sentiment Analyse-Verfahren für die quantitative Untersuchung von Lessings Dramen“ schildern Schmidt et al. (2018b) das Vorgehen der webbasierten Tool-Entwicklung sowie Ergebnisse der Fallstudien des Lustspiels “Minna von Barnhelm”.

Die Analyse von Minna von Barnhelm zeigt, dass die negativen emotionalen Bewertungen insgesamt gegenüber den positiven deutlich überwiegen. Dieser Befund bestätigt die bekannte Erkenntnis, dass Lessing das Schema des rührenden Lustspiels verwendet hat. Während die Komik im Stück eher das Ergebnis von Schlussprozessen ist, geht es auf der wörtlichen Ebene überwiegend um ernste Vorwürfe und drohenden Identitäts- und Beziehungsverlust.

Paper empirische Annotationsstudie:

- Link zur Präsentation

- Link zum Paper im Tagungsband

- Link zum Paper auf ResearchGate

- Link zum Paper auf ePub

- Link zum Repositorium des Korpus

- Link zur Workshop-Seite

Paper Evaluation & Tool:

- Link zum Poster

- Link zum Paper im Tagungsband

- Link zum Paper auf ResearchGate

- Link zum Paper auf ePub

- Link zum Repositorium des Korpus

- Link zum Repositorium des Tools

- Link zur Sentiment Analysis-Komponente von Katharsis

- Link zur Workshop-Seite

2. Sentiment Annotation for Lessing’s Plays: Towards a Language Resource for Sentiment Analysis on German Literary Texts

Um herauszufinden, wie wichtig das Fachwissen in einer Annotationsstudie ist und ob es geeignet wäre, Benutzer*innen via Crowdsourcing für zukünftige Annotationen in historischen Texten zu rekrutieren, führen Schmidt et al. (2019a) Sentiment-Annotation auf Lessings Dramen mit einer Gruppe Semi-Expert*innen durch.

In Kooperation mit dem Masterstudiengang Germanistik an der Universität Würzburg wurden neun Studierende des Seminars „Sentiment Analysis vs. Affektlehre“ in das Annotationsprojekt eingeleitet. Jede Annotierende soll für 200 Repliken Stimmungskommentare erstellen, die zufällig aus dem Korpus ausgewählt werden (einige haben eine Ausnahme von 183 Repliken). Das Korpus ist aus sechs der berühmtesten Dramen von Lessing aufgebaut und umfasst 1 183 Repliken. Das Korpus ist auch online verfügbar.

Der Gesamtablauf ist sehr ähnlich und vergleichbar wie das, was oben bzw. im Paper „Sentiment Annotation of Historic German Plays: An Empirical Study on Annotation Behavior“ beschrieben wird. Jede Annotierende erhielt eine Datei mit den stückspezifischen Repliken, die mit den folgenden Informationen gegeben werden: Name des Sprechers, Text und Position der Rede im gesamten Stück und einige Kontextinformationen.

In zwei vordefinierten Tabellen sollen die Sentiment-Annotationen markiert werden. Zunächst können die Annotierenden sich zwischen negativ, positiv, neutral, gemischt, unsicher und andere (die sogenannte differenzierte Polarität) entscheiden. Anschließend sollen sie eine eindeutige Anmerkung zwischen negativ und positiv (die binäre Polarität) angeben.

Die Semi-Expert*innen wurden angewiesen, die allgemeine Stimmung innerhalb der gegebenen Replik anzumerken und nicht die Stimmung für bestimmte Teile. Falls es mehrere, eventuell widersprüchliche Sentimentangaben in einer Rede gab, soll nur das dominanteste Sentiment notiert.

Das annotierte Korpus umfasst 2 366 Annotationen (2 Annotationen pro Replik) und hat einen eher negativen Tendenz, da die meisten Anmerkungen negativ sind und eine erhebliche Anzahl von Kommentaren gemischt und unsicher ist.

Zur Analyse der Übereinstimmung zwischen den Annotator*innen wurden Cohen’s Kappa und die durchschnittliche Übereinstimmungsquote (average observed agreement, AOA) als Metriken verwendet. Der Wertebereich von Cohen’s Kappa liegt zwischen 0 und 1, wobei 0 für geringe und 1 für große Übereinstimmung steht. Die AOA hingegen ist die Anzahl der Übereinstimmungen geteilt durch die Gesamtzahl der annotierten Reden.

Darüber hinaus wird aus den vorhandenen Annotationen eine dritte Variante als Metrik abgeleitet, die Schmidt et al. (2019a) als dreifache Polarität (threefold polarity) bezeichnen. Grundsätzlich wird aus der binären Polarität um den Wert „neutral“ erweitert, d. h. wenn bei der differenzierten Polarität die Anmerkung „neutral“ vorkommt, wird diese in die dreifache Polarität übernommen. Für alle anderen Fälle wird der Wert „positiv“ oder „negativ“ aus der binären Polaritätsannotation übernommen.

Bei den Annotationsarten mit weniger Polaritätsklassen sind Kappa-Werte mit moderater Übereinstimmungsrate (0,41 – 0,60) zu sehen. In den Annotationen der beiden bürgerlichen Trauerspiele Emilia Galotti und Miß Sara Sampson werden die höchsten Korrelationen gefunden (0,61 – 0,80). Diese sind Beweise dafür, dass die Wahrnehmung von Gefühlen in literarischen Texten sehr subjektiv ist und von der Interpretation der Annotierenden abhängt.

Im Vergleich zu der ähnlichen Annotationsstudie mit Teilnehmer*innen, die weniger Expertise haben, werden jedoch höhere Übereinstimmungen erzielt. Daher ziehen Schmidt et al. (2019a) das Fazit, dass Annotationsaufgaben zum historischen bzw. literarischen Text von fachkundigen Expert*innen zu untersuchen sind, um stabilere Ergebnisse zu erhalten.

- Link zum Paper im Tagungsband

- Link zum Paper auf ePub

- Link zum Paper auf ResearchGate

- Link zum Poster

- Link zum Repositorium des Korpus

3. Toward Multimodal Sentiment Analysis of Historic Plays: A Case Study with Text and Audio for Lessing’s Emilia Galotti

Bislang werden Sentimentanalysen hauptsächlich für Produkt-Reviews oder Social-Media-Analysen verwendet. Im Forschungsfeld der Computational Literary Studies jedoch besteht ein steigendes Interesse, Sentimentanalysen für den literarischen Text zu verwenden. Bisherige Versuche beziehen sich jedoch hauptsächlich auf den geschriebenen Text und lassen andere mediale Kanäle wie Audioversionen oder Film außer Acht. Auch im literarischen Text schwankt die Genauigkeit und Treffsicherheit der Sentiment-Analyse zwischen 20% und 70%. Ein Grund für diese niedrigen Quoten kann zum Beispiel sein, dass Theaterstücke für die Aufführung, also mündliche Performance, geschrieben worden sind. Emotionen werden also auch durch Szenenbild und Schauspieler*innen vermittelt.

Im Paper „Toward Multimodal Sentiment Analysis of Historic Plays: A Case Study with Text and Audio for Lessing’s Emilia Galotti” verfolgen die Autoren Thomas Schmidt, Prof. Manuel Burghardt und Prof. Christian Wolff deshalb den Ansatz, eine multimodale Sentimentanalyse durchzuführen. Idee ist, dass unterschiedliche mediale Kanäle die Annotation von Emotionen in narrativen Texten verbessern können. Bisher war die Annotation von Dramen auf Grund ihrer komplexen und historischen Sprache eine Herausforderung. Anhand des bürgerlichen Trauerspiels Emilia Galotti von Gotthold Ephraim Lessing haben die Autoren eine multimodale Sentimentanalyse durchgeführt, bei der die Sentiment-Analyse einer Textversion und eines Hörbuchs des Stücks durchgeführt wurde. Dabei wurden gebrauchsfertige Tools verwendet. Für den Text wurde ein lexikonbasierter Ansatz implementiert, sowie ein weiterer Ansatz, der diesen um diverse Methoden des Natural Language Processings (computerbasierte Sprachverarbeitung) erweitert. Für das Hörbuch wurde die kostenlose Version des Vokaturi-Tools verwendet. Die Ergebnisse wurden mit den Annotationen eines professionellen menschlichen Annotators verglichen, der als Goldstandard gilt. So soll den beiden Forschungsfragen

(1) „Wie schneiden textbasierte Sentimentanalysen im Vergleich zu einem gebrauchsfertigen Audio-Sentiment-Analyse-Ansatz ab?“ und

(2) „Wie gut funktionieren Ansätze der textuellen Sentiment-Analyse und der Audio-Sentiment-Analyse im Vergleich zu menschlichen Expertenannotationen (mit Text)?“

beantwortet werden. Die Sentiment-Analyse des Texts mit dem naiven, gebrauchsfertigen Tool erreichte den Erkennungswert von 52%. Das um Methoden des Natural Language Processing erweiterte Tool erreicht den Erkennungswert von 56%. Am Schlechtesten schneidet die Sentimentanalyse des Hörspiels mit einem Wert von 31% ab, was unter der Zufallsquote von 36% liegt. Historische Erzähltexte erweisen sich weiterhin als eine sehr anspruchsvolle Textsorte für die Stimmungsanalyse. Grund dafür ist vor allem, dass sowohl der menschliche Annotator als auch die Textanalyse die Mehrheit der Reden als negativ einstuft, während die Audio-Sentiment-Analyse Stimmungsanalyse sich gegenteilig verhält. In zukünftiger Forschung sollen weitere Möglichkeiten erforscht werden, mehrere mediale Kanäle zu kombinieren, um die Leistungsfähigkeit zu steigern.

Darüber hinaus soll auch der Medienkanal Video in zukünftige Forschung einbezogen werden, insbesondere die Erkennung von Gesichtsemotionen über Videoaufzeichnungen von Theateraufführungen der Stücke. Die Einbeziehung des mündlichen Ausdrucks, aber auch der Mimik eines Schauspielers bieten die notwendigen Interpretationskanäle für ein ganzheitliches Verständnis der Stimmung und Emotion in einem Theaterstück.

- Link zum Paper auf ResearchGate

- Link zum Paper auf ePub

- Link zum Paper im Tagungsband

- Link zum gesamten Tagungsband der DHN 2019

Literatur:

Schmidt, T. & Burghardt, M. (2018). An Evaluation of Lexicon-based Sentiment Analysis Techniques for the Plays of Gotthold Ephraim Lessing. In: Proceedings of the Second Joint SIGHUM Workshop on Computational Linguistics for Cultural Heritage, Social Sciences, Humanities and Literature (pp. 139-149). Santa Fe, New Mexico: Association for Computational Linguistics.

Schmidt, T., Burghardt, M. & Dennerlein, K. (2018a). Sentiment Annotation of Historic German Plays: An Empirical Study on Annotation Behavior. In: Sandra Kübler, Heike Zinsmeister (eds.), Proceedings of the Workshop on Annotation in Digital Humanities (annDH 2018) (pp. 47-52). Sofia, Bulgaria.

Schmidt, T., Burghardt, M. & Dennerlein, K. (2018b). „Kann man denn auch nicht lachend sehr ernsthaft sein?“ – Zum Einsatz von Sentiment Analyse-Verfahren für die quantitative Untersuchung von Lessings Dramen. In Book of Abstracts, DHd 2018.

Schmidt, T., Burghardt, M., Dennerlein, K. & Wolff, C. (2019a). Sentiment Annotation in Lessing’s Plays: Towards a Language Resource for Sentiment Analysis on German Literary Texts. In: 2nd Conference on Language, Data and Knowledge (LDK 2019). LDK Posters. Leipzig, Germany.

Schmidt, T., Burghardt, M. & Wolff, C. (2019b). Towards Multimodal Sentiment Analysis of Historic Plays: A Case Study with Text and Audio for Lessing’s Emilia Galotti. In: In Proceedings of the Digital Humanities in the Nordic Countries 4th Conference (DHN 2020) (pp. 405-414). Copenhagen, Denmark.

Schreibe einen Kommentar