Aenne Knierim und Thomas Schmidt

Abstract

Aufgrund des Ausfalls der jährlichen Digital Humanities-Tagung des Verbandes Digital Humanities in the Nordic & Baltic Countries in 2021 gab es dieses Jahr die Möglichkeit, aufbauend auf Einreichungen der Tagung 2020, längere und erweiterte Versionen von angenommenen Beiträgen in einem erneuten Peer-Review-Verfahren für einen sogenannten Post Proceedings-Band einzureichen und zu publizieren. Die Post Proceedings sind öffentlich zugänglich und man findet sie hier. Aufbauend auf einem Late-Breaking-Poster von der Tagung 2020 haben Mitarbeiter des Lehrstuhls für Medieninformatik und eine Studierende des Digital Humanities-Masters ein Paper eingereicht und publiziert, in welchem Ergebnisse zur Entwicklung und Evaluation einer innovativen Live-Sentiment-Annotation von Filmen präsentiert werden. Der Beitrag stammt von: Thomas Schmidt, Isabella Engl, David Halbhuber und dem Lehrstuhlinhaber der Medieninformatik Christian Wolff. Im Folgenden wird das Forschungsprojekt beschrieben und dazugehörige Ressourcen geteilt.

Sentiment Analyse und Sentiment Annotation

In den Digital Humanities bezeichnet Annotation die Anreicherung kultureller Artefakte mit zusätzlichen Informationen. Annotationen spielen beispielsweise eine wichtige Rolle, um Artefakte mit wertvollen Metainformationen auszuzeichnen oder werden genutzt, um moderne Algorithmen des maschinellen Lernens zu trainieren und zu evaluieren. Betrachtet man die letztjährige Special Issue des Journals Digital Humanities Quarterly: „Digital Humanities & Film Studies: Analyzing the Modalities of Moving Images“ findet man auch für die computergestützte Filmanalyse vielfältige Anwendungsfälle wie die Annotation von Metainformationen über Crowdsourcing (Salmi et al., 2020) oder auch die Annotation von Schnittlängen (Tsivian, 2009), Personen und Objekten (Hielscher, 2020), um dem hermeneutischen Ansatz ein objektiveres und tieferes Verständnis von Filmen hinzuzufügen. Das Paper „Comparing Live Sentiment Annotation of Movies via Arduino and a Slider with Textual Annotation of Subtitles“ (Schmidt et al., 2020) ist dem Kontext der Entwicklung und Evaluierung von Tools und dem Einfluss verschiedener Faktoren auf die Qualität der Annotation zuzuordnen und betrachtet speziell den Anwendungsbereich der Sentiment-Annotation für Filme.

Sentiment Analyse ist ein Forschungsbereich, der sich mit der computergestützten Analyse und Erkennung von Gefühlen, Sentiment, Polarität und Emotionen, vor allem im geschriebenen Text, beschäftigt. Unter Sentiment oder Polarität versteht man dabei, ob ein Text eher positiv oder negativ konnotiert ist. Eine wichtige Ressource für die Sentiment Analyse sind große Korpora mit Texteinheiten, die von Menschen mit Sentiment-Information ausgezeichnet wurden. Diese können genutzt werden, um moderne Algorithmen des maschinellen Lernens zu trainieren. Beispiele für solche Korpora im Dramen-Bereich findet man hier (Schmidt et al., 2018a). In diesen Beispielen wurde für einzelne Sprechakte annotiert ob der Text eher positiv oder negativ konnotiert ist. Bei der Erstellung dieser Korpora gilt es einige Herausforderungen zu überwinden: Da die Wahrnehmung von Gefühlen und Emotionen in narrativen Texten sehr subjektiv und interpretativ sein kann, gibt es in diesem Kontext häufig sehr geringe Übereinstimmungen bei Annotationen, was für zahlreiche narrative Textsorten empirisch belegt werden konnte (für eine Übersicht siehe Schmidt et al., 2018b). Für maschinelles Lernen sind jedoch Korpora mit möglichst hohen Übereinstimmungen wichtig, um Unschärfe des Annotationskonzepts zu vermeiden. Des Weiteren ist die Annotation von narrativen Texten anstrengend und zeitintensiv was die Erstellung großer Korpora ebenso hemmt. Im Kontext der Filmanalyse besteht auch die Problematik, dass sich Annotationen auf textuelle Inhalte wie Untertitel und Skripte fokussieren (siehe Bild 1). Eine Übersicht über potentielle Tools für textuelle Sentiment-Annotation findet man bei Schmidt et al. (2019).

Bild 1: Beispiel für eine Form der Film-Annotation über Untertitel (Avengers)

Schmidt et al. (2020) argumentieren jedoch, dass beim Film Informationen nicht nur über die textuelle Ebene übertragen werden: Der Film ist ein multimediales Artefakt. Gefühle werden über Gesicht und Stimme des Schauspielers übertragen sowie über zusätzliche Aspekte wie Musik, Farbe und Kameraperspektive dargestellt. Es ist also zunächst naheliegend, dass Zuschauer*Innen eher in der Lage sind, Sentiment während des Filmschauens zu annotieren, als auf der bloßen Grundlage der schriftlichen Untertitel. Schmidt et al. (2020) untersuchen, ob der Annotationsprozess durch Live-Annotation während des Filmschauens vereinfacht wird und eine höhere Validität besitzt als rein textuelle Annotationen. Die Annahme ist dabei, dass die Annotation während des Filmschauens näher an der emotionalen Realität ist als eine Post-hoc Annotation. Es besteht auch die Annahme, dass ein Tool, das kontinuierliche Annotationen erlaubt dem intuitiven und subjektiven Annotatationsprozess der Sentiment-Annotation eher entspricht.

Live-Sentiment-Annotation von Filmen

Um die obige Fragestellung zu untersuchen, haben Thomas Schmidt und David Halbhuber vom Lehrstuhl für Medieninformatik bereits 2020 ein Annotationssystem entwickelt und in einem Late-Breaking-Poster bei der virtuellen Instanz der jährlichen DHNord-Tagung präsentiert (Schmidt & Halbhuber, 2020). Das Poster findet man hier.

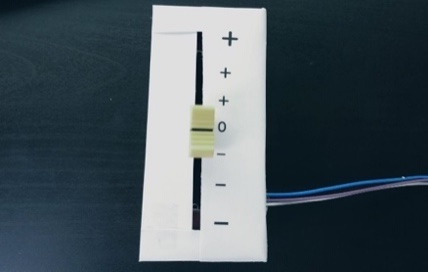

Das Annotationssystem selbst setzt sich aus einem Arduino Microcontroller, der mit einem Potentiometer verbunden ist, zusammen (siehe Bild 2). Dieses ist mit einem Slider gepaart; der Arduino selbst ist mit einem Computer verbunden, auf dem ein Python-Skript läuft (siehe Bild 3).

Das Skript liefert als Output eine Tabelle, die den Wert des Sliders für alle 100 ms ausgibt. Die Idee ist, dass eine Annotator*in während dem Anschauen des Films den Slider auf einer kontinuierlichen Skala hoch und runter bewegen kann, um live zu markieren welche Polaritäts-Ausprägung der Film momentan hat (positiv vs negativ). Ein User Interface auf dem Bildschirm gibt Feedback über die momentan gewählte Annotation (siehe Bild 4 und 5).

Zum Vergleich und zur Validierung der Live-Sentiment-Annotation wurde eine empirische Studie an kommerziellen und kanonischen Filmen verschiedener Genres durchgeführt, die Live- und textuelle Annotation mittels Untertitel vergleicht. Es wurden die folgenden Filme annotiert:

- Das Fenster zum Hof (1954)

- Schöne Bescherung (1989)

- Scream (1996)

- Avengers (2012)

- Das Schicksal ist ein mieser Verräter (2014)

Jeder Film wurde von 3 Annotator*Innen für jede Methode annotiert, d.h. 15 Annotationen für jeweils die textuelle und die live-Annotation, wobei kein Annotator*In einen Film mehr als einmal annotierte. Für die textuelle Annotation wurde die Polarität einzelner Untertitel in einer Tabelle auf einer Skala von -5 bis +5 annotiert ohne Zugang zum Film. Für die Live-Annotation wurde der Film im Labor der Medieninformatik angeschaut und der Slider zur Annotation genutzt (siehe Bild 6) (Die Studie wurde vor Beginn der Corona-Pandemie durchgeführt). Die einzelnen Annotationen wurden zeitlich und mathematisch aufeinander sowie heuristisch auf die drei Polaritätsklassen negative, neutral und positiv gemappt, um Übereinstimmungen zu untersuchen. Des Weiteren wurde über Fragebögen und Interviews die empfundene Schwierigkeit und die Einschätzung des jeweiligen Annotationsverfahrens untersucht.

Die Ergebnisse zeigen, dass Teilnehmer*Innen die textuelle Annotation als sehr viel schwieriger und anstrengender wahrnehmen und sie sich auch bei der Annotation unsicherer waren. Das Fehlen des Videokanals und des mit Untertiteln schwieriger zu erschließenden Kontexts wurde bemängelt. Während die Live-Annotation als angenehmer wahrgenommen wurden, traten neue Herausforderungen auf, wie der Umgang mit schnellem Szenenwechsel. Auch der Umgang mit mehreren Charaktere auf dem Bildschirm, die verschiedene Emotionen aufzeigen stellte für die Annotierenden eine Herausforderung dar. Da die Filme in etwa zwei Stunden lang waren, verlangte die Live-Annotation eine lange Konzentrationsspanne, die textuelle Annotation benötigte im Schnitt absolut 20 Minuten mehr.

Sowohl bei der Live-Annotation als auch bei der textuellen Annotation war die Übereinstimmung in der Polärität-Bewertung erneut niedrig, was den subjektiven Charakter von Annotationen für narrative Medien verdeutlicht. Übertragen auf die Zeiteinheiten der Untertitel und für die Polaritätsklassen negativ, neutral und positiv stimmen Annotator*Innen lediglich in 50% der Fälle für textuelle und 56% für live-Annotation überein. Zukünftige Forschung soll zeigen, wie Langzeitstudien und Training der Annotator*Innen eventuell eine Verbesserung der Übereinstimmung herbeiführen können. Mehr Informationen zum Studiendesign und den Ergebnissen findet man im Paper.

Präsentierte Paper:

Schmidt, T. & Halbhuber, D. (2020). Live Sentiment Annotation of Movies via Arduino and a Slider. In Digital Humanities in the Nordic Countries 5th Conference (DHN 2020). Late Breaking Poster. [poster]

Schmidt, T., Engl, I., Halbhuber, D., & Wolff, C. (2020). Comparing Live Sentiment Annotation of Movies via Arduino and a Slider with Textual Annotation of Subtitles. In DHN Post-Proceedings (pp. 212-223). [pdf]

Kontakt zu den AutorInnen:

Thomas Schmidt

Isabella Engl

- Isabella.engl@stud.uni-regensburg.de

David Halbhuber

Christian Wolff

Literatur:

Hielscher, E. (2020). The Phenomenon of Interwar City Symphonies: A Combined Methodology of Digital Tools and Traditional Film Analysis Methods to Study Visual Motifs and Structural Patterns of Experimental-Documentary City Films. DHQ: Digital Humanities Quarterly, 14(4). [html]

Salmi, H., Laine, K., Römpötti, T., Kallioniemi, N., & Karvo, E. (2020). Crowdsourcing Metadata for Audiovisual Cultural Heritage: Finnish Full-Length Films, 1946-1985. In: DHN, pp. 325-332. [pdf]

Schmidt, T., Burghardt, M. (2018). An evaluation of lexicon-based sentiment analysis techniques for the plays of Gotthold Ephraim Lessing. In: Proceedings of the Second Joint SIGHUM Workshop on Computational Linguistics for Cultural Heritage, Social Sciences, Humanities and Literature, pp. 139–149. Association for Computational Linguistics. [pdf]

Schmidt, T., Burghardt, M., Dennerlein, K. (2018a). Sentiment annotation of historic german plays: An empirical study on annotation behavior. In: Kübler, S., Zinsmeister, H. (eds.) Proceedings of the Workshop for Annotation in Digital Humantities (annDH), pp. 47–52. Sofia, Bulgaria. [pdf]

Schmidt, T., Burghardt, M., & Wolff, C. (2018b). Herausforderungen für sentiment analysis-verfahren bei literarischen texten. INF-DH-2018. http://dx.doi.org/10.18420/infdh2018-16 [pdf]

Schmidt, T., Burghardt, M., Dennerlein, K. & Wolff, C. (2019). Sentiment Annotation in Lessing’s Plays: Towards a Language Resource for Sentiment Analysis on German Literary Texts. In: 2nd Conference on Language, Data and Knowledge (LDK 2019). LDK Posters. Leipzig, Germany. [pdf] [poster]

Schmidt, T., Burghardt, M. & Wolff, C. (2019). Towards Multimodal Sentiment Analysis of Historic Plays: A Case Study with Text and Audio for Lessing’s Emilia Galotti. In: Proceedings of the DHN (DH in the Nordic Countries) Conference, pp. 405-414. Copenhagen, Denmark . [pdf]

Schmidt, T., Engl, I., Halbhuber, D., & Wolff, C. (2020). Comparing Live Sentiment Annotation of Movies via Arduino and a Slider with Textual Annotation of Subtitles. In DHN Post-Proceedings (pp. 212-223). [pdf]

Schmidt, T. & Halbhuber, D. (2020). Live Sentiment Annotation of Movies via Arduino and a Slider. In Digital Humanities in the Nordic Countries 5th Conference (DHN 2020). Late Breaking Poster. [poster]

Schmidt, T., Winterl, B., Maul, M., Schark, A., Vlad, A. & Wolff, C. (2019). Inter-Rater Agreement and Usability: A Comparative Evaluation of Annotation Tools for Sentiment Annotation. In: Draude, C., Lange, M. & Sick, B. (Eds.), INFORMATIK 2019: 50 Jahre Gesellschaft für Informatik – Informatik für Gesellschaft (Workshop-Beiträge), pp. 121-133. Bonn: Gesellschaft für Informatik e.V.. http://dx.doi.org/10.18420/inf2019_ws12 [pdf]

Tsivian, Y.: Cinemetrics, part of the humanities’ cyberinfrastructure. (2009). Retrieved from https://www.degruyter.com/document/doi/10.14361/9783839410233-007/html

Schreibe einen Kommentar