Manuel Burghardt

Vortrag im Rahmen des DH-Kolloquiums der Berlin-Brandenburgischen Akademie der Wissenschaften

Abstract

Unter dem Schlagwort Digital Humanities wird gemeinhin der Einsatz digitaler Ressourcen und computergestützter Methoden in den Geisteswissenschaften zusammengefasst. Vor dem Hintergrund bestehender Methoden im Bereich der Korpus- und Computerlinguistik liegt hier bislang ein starker Fokus auf textbasierten Wissenschaften (vgl. etwa das Konzept des Distant Reading). In zunehmendem Maße rücken in den Digital Humanities nun aber auch andere geisteswissenschaftliche Disziplinen in den Fokus computergestützter Modellierungs- und Analyseversuche, etwa im Bereich der Kunstgeschichte (Bild), der Filmwissenschaft (Film) und der Musikwissenschaft (Musik). Entsprechend ist der Vortrag im Schnittfeld von Digital Humanities und Musikwissenschaft zu verorten. Dabei sollen anhand eines konkreten Projekts zur Digitalisierung einer großen Sammlung handschriftlicher Liedblätter grundlegende Möglichkeiten und Methoden zu Erschließung, Repräsentation und Analyse von notierter Musik aufgezeigt werden. Wenngleich an vielen Stellen Parallelen zu Methoden und Verfahren aus den textbasierten Geisteswissenschaften offenkundig werden, so wird doch auch deutlich, dass es sich bei „Notentext“ um mehr als nur Wörter handelt und sich somit einige Besonderheiten und Herausforderungen bei der Digitalisierung ergeben.

Zum Thema Erschließung werden im Rahmen des Vortrags zunächst bestehende Tools aus dem Bereich der optical music recognition (OMR) vorgestellt, die allerdings für handschriftlich notierte Musik nur begrenzt einsetzbar ist (Burghardt et al., 2017). Als Alternative wird ein Crowdsourcing-Ansatz zur Transkription der Melodien vorgestellt (Meier et al., 2015; Burghardt & Spanner, 2017). Weiterhin zeigt der Vortrag unterschiedliche Ebenen der Repräsentation von Melodien auf, bspw. als exakt notierte Melodie, als Abfolge von Intervallen oder als abstrakte Melodiekontur (Parsons Code). Außerdem werden bestehende Speicherformate für die Repräsentation von Musikinformation (bspw. MusicXML und MEI) vorgestellt und diskutiert. Im letzten Teil des Vortrags werden schließlich grundlegende Möglichkeiten der computergestützten Analyse digitalisierter Musikdaten aufgezeigt und dabei grundlegende Konzepte des music information retrieval, insbesondere der melodic similarity, eingeführt (Burghardt et al., 2015; Burghardt et al., 2016; Burghardt & Lamm, 2017). Darüber hinaus soll aufgezeigt werden, welche neuartigen Fragestellungen durch computergestützte Ansätze in der Musikwissenschaft bearbeitet werden können.

Literatur

- Burghardt, M., & Lamm, L. (2017). Entwicklung eines Music Information Retrieval-Tools zur Melodic Similarity-Analyse deutsch-sprachiger Volkslieder. In M. Eibl & M. Gaedke (Eds.), INFORMATIK 2017, Lecture Notes in Informatics (LNI), Gesellschaft für Informatik – Workshop „Musik trifft Informatik“ (pp. 15–27). Bonn: Springer.

- Burghardt, M., & Spanner, S. (2017). Allegro: User-centered Design of a Tool for the Crowdsourced Transcription of Handwritten Music Scores. In Proceedings of the DATeCH (Digital Access to Textual Cultural Heritage) conference. ACM.

- Burghardt, M., Spanner, S., Schmidt, T., Fuchs, F., Buchhop, K., Nickl, M., & Wolff, C. (2017). Digitale Erschließung einer Sammlung von Volksliedern aus dem deutschsprachigen Raum. In Book of Abstracts, DHd 2017.

- Burghardt, M., Lamm, L., Lechler, D., Schneider, M., & Semmelmann, T. (2016). Tool‑based Identification of Melodic Patterns in MusicXML Documents. In Book of Abstracts of the International Digital Humanities Conference (DH).

- Burghardt, M., Lamm, L., Lechler, D., Schneider, M., & Semmelman, T. (2015). MusicXML Analyzer – Ein Analysewerkzeug für die computergestützte Identifikation von Melodie-Patterns. In Proceedings des 9. Hildesheimer Evaluierungs- und Retrievalworkshop (HiER 2015) (pp. 29–42).

- Meier, F., Bazo, A., Burghardt, M., & Wolff, C. (2015). A Crowdsourced Encoding Approach for Handwritten Sheet Music. In J. Roland, Perry; Kepper (Ed.), Music Encoding Conference Proceedings 2013 and 2014 (pp. 127–130).

Vortrag und Ressourcen

„More than Words“ – vom Text zur Musik

Franco Morettis Konzept des „Distant Reading“ ist eine zentrale Metapher in den Digital Humanities, die sich mittlerweile auf viele weitere Bereiche ausgedehnt hat, bspw.

- Distant Viewing bei Bildern, vgl. Manovich et al. (2011). How to Compare One Million Images?

- Distant Watching bei Filmen, vgl. http://www.cinemetrics.lv/

Ansätze zu „Distant Hearing„, also computergestützter Analyse von Musikdaten, sind bislang in der Digital Humanities-Community noch relativ selten, dafür aber im Informatikbereich unter dem Schlagwort Music Information Retrieval (MIR) schon seit vielen Jahren etabliert. Eine zentrale Organisation und gleichlautende Konferenz ist dabei die ISMIR (International Society for Music Information Retrieval).

- www.ismir.net

Grundsätzlich unterscheidet man im MIR zwischen Ansätzen im Bereich der Signalverarbeitung (Audio) und der Symbolverarbeitung (Noten).

- Audio Labs Erlangen: https://www.audiolabs-erlangen.de/

- Beethovens Werkstatt: http://beethovens-werkstatt.de/

Der Vortrag fokussiert auf symbolische Musik, also Notenblätter. Konkret werden Herausforderungen und Besonderheiten („notes are more than words“) bei der computergestützten Erschließung, Modellierung und Analyse anhand der Regensburger Liedblattsammlung aufgezeigt.

Fallstudie: Regensburger Liedblattsammlung

Es handelt sich bei diesem Projekt um eine Kooperation mit der Universitätsbibliothek Regensburg, die im Besitz einer – was Umfang und Abdeckung angeht – einzigartigen Liedblattsammlung deutschsprachiger Volkslieder ist.

- Regensburger Volksmusikportal (RVP): http://rvp.ur.de/

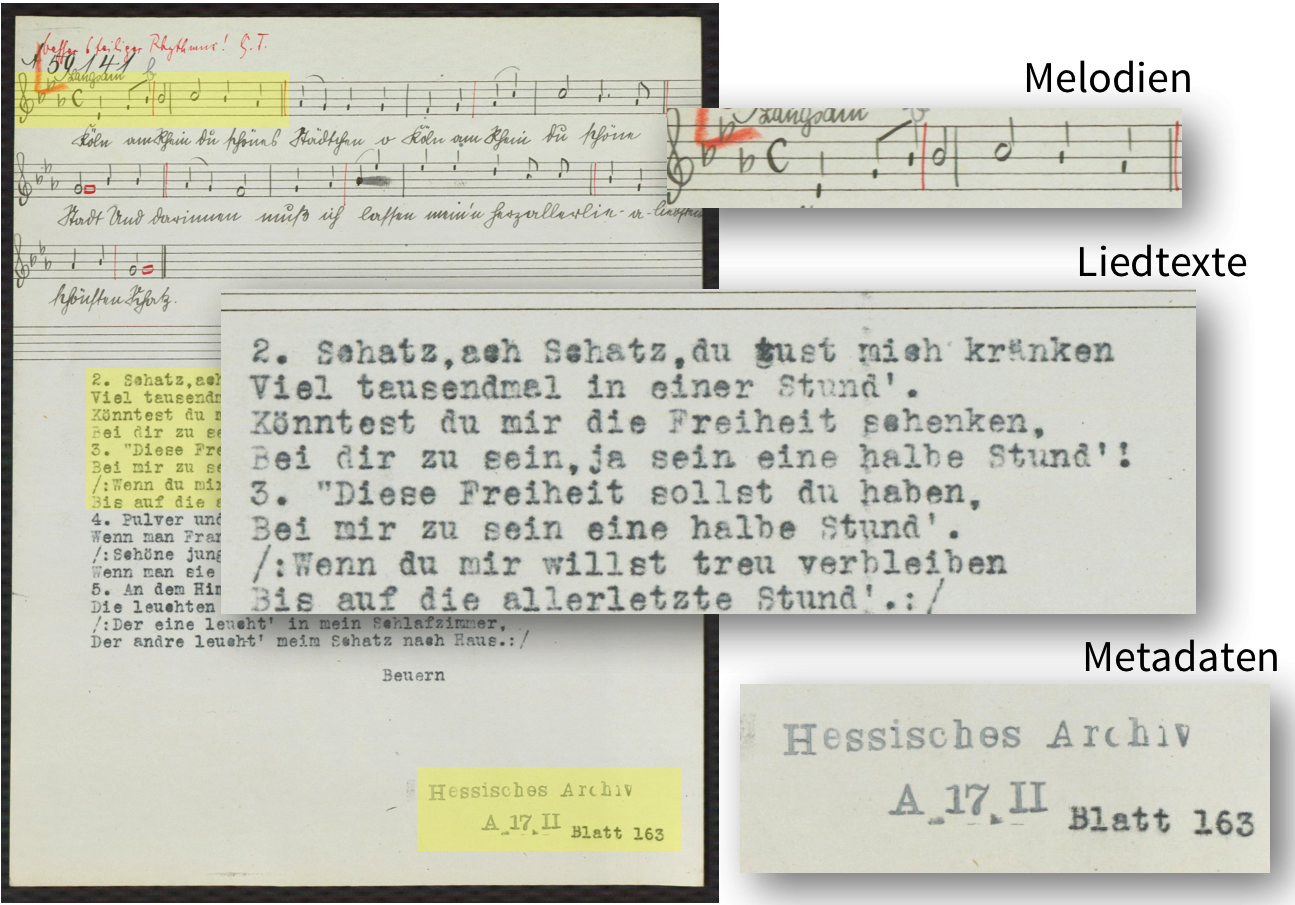

Die ca. 140.000 Liedblätter enthalten handschriftliche, monophone Melodien, meist mit Schreibmaschine getippte Liedtexte sowie diverse Metadaten wie etwa Archivort, Jahr und Liedblattnummer.

Weiterführende Informationen zur Liedblattsammlung:

- Krüger, G. (2013). Das „Regensburger Volksmusik-Portal“ der Universitätsbibliothek Regensburg. Bestände – Problematiken – Perspektiven. Zwischenbericht aus einem Erschließungsprojekt. In E. R. Mohrmann (Ed.), Audioarchive – Tondokumente digitalisieren, erschließen und auswerten (p. 119–131). Münster et al.: Waxmann Verlag.

(I) Maschinenlesbare Erschließung / Digitalisierung

Übersicht zu Optical Music Recognition (OMR) Tools: http://homes.soic.indiana.edu/donbyrd/OMRSystemsTable.html

Aktuelle OMR-Tools:

- Audiveris: https://github.com/audiveris

- Capella: https://www.capella-software.com/de/index.cfm/produkte/capella-scan/info-capella-scan/

- PhotoScore: http://www.neuratron.com/photoscore.htm

- SharpEye: http://www.music-scanning.com/sharpeye.html

- SmartScore: http://www.musitek.com/

Bestehende Sammlung mit Scans:

- Petrucci Music Library (IMSLP): http://imslp.org/

- Vgl. auch Peachnote, Ngram-Viewer für Digitalisate der IMSLP (ISMIR-Paper, 2011): www.peachnote.com

Bestehende Sammlungen mit transkribierter Musik:

- MuseScore: https://musescore.com/sheetmusic

- OpenScore: https://musescore.com/openscore

- OpenMusicScore: http://openmusicscore.org/

- Gutenberg Sheet Music Project: http://www.gutenberg.org/wiki/Gutenberg:The_Sheet_Music_Project

- ChoralWiki: http://www3.cpdl.org/wiki/index.php/Main_Page

- Essen Folksong Collection: http://kern.ccarh.org/browse?l=essen

- ABC TuneSearch: http://abcnotation.com/search

Leider funktioniert OMR bei handschriftlichen Notenblättern nur sehr schlecht:

OMR for handwritten scores as a major unresolved problem (Müller, 2007)

Diese Einschätzung bestätigte sich auch durch die Evaluation von drei bestehenden OMR-Tools für die Regensburger Liedblattsammlung. Evaluationsdesign angelehnt an Bellini, Bruno & Nesi (2007). Durchschnittliche Erkennungsraten: Photoscore (36%), CapellaScan (8%) und SharpEye (4%).

Nähere Informationen zur Evaluationsstudie:

- Burghardt, M., Spanner, S., Schmidt, T., Fuchs, F., Buchhop, K., Nickl, M., and Wolff, C. (2017). Digitale Erschließung einer Sammlung von Volksliedern aus dem deutschsprachigen Raum. In Book of Abstracts, DHd 2017.

Da OMR wegen der schlechten Ergebnisse nicht in Frage kommt, wird Crowdsourcing als alternative Erschließungsstrategie gewählt, denn Transkription zählt nach Oomen & Aroyo (2011) zu den typischen Anwendungsgebieten von Crowdsourcing:

- Contextualization

- Complementing collections

- Classification

- Co-curation

- Crowdfunding

- Correction and transcription

Bestehende Tools zur Transkription, die aber allesamt nicht für einen Remote-Crowdsourcing-Ansatz geeignet sind.

| Name | Type | Source |

| Flat.io | Web | https://flat.io/ |

| Noteflight | Web | https://www.noteflight.com |

| Sibelius | Desktop | http://www.avid.com/en/sibelius |

| MuseScore | Desktop | https://musescore.org/ |

Allegro

Entwicklung eines eigenen Crowdsourcing-Tools namens Allegro, welches die folgenden Anforderungen erfüllt:

- webbasiert (HTML / JavaScript) und parallel von mehreren Transkriptoren benutzbar

- einfach zu bedienen (entwickelt mithilfe eines systematischen UCD-Ansatzes), so intuitiv, dass es auch für Musik-Laien möglich ist Teanskriptionen zu erstellen

- Try Allegro: http://138.68.106.29/

Nähere Informationen zu Allegro in:

- Burghardt, M., & Spanner, S. (2017). Allegro: User-centered Design of a Tool for the Crowdsourced Transcription of Handwritten Music Scores. In Proceedings of the DATeCH (Digital Access to Textual Cultural Heritage) conference. ACM.

OMR-Literatur

- Bainbridge, D. and Bell, T. (2001). The challenge of optical music recognition. In Computers and the Humanities, 35, p. 95–121.

- Bellini, P., Bruno, I., and Nesi, P. (2007). Assessing optical music recognition tools. In Computer Music Journal, 31(1), 68–93.

- Grachten, M., Arcos, J. L., and de Mántaras, R. L. (2002). A comparison of different approaches to melodic similarity. In Proceedings of the 2nd International Conference in Music and Artificial Intelligence (ICMAI).

- Homenda, W. and Luckner, M. (2006). Automatic Knowledge Acquisition: Recognizing Music Notation with Methods of Centroids and Classifications Trees. In Proceedings of the IEEE International Joint Conference on Neural Network, p. 6414–6420.

- Raphael, C. and Wang, J. (2011). New Approaches to Optical Music Recognition. In Proceedings of the 12th International Society for Music Information Retrieval Conference (ISMIR), p. 305–310.

- Rebelo, A., Capela, G., and Cardoso, J. S. (2010). Optical recognition of music symbols. In International Journal on Document Analysis and Recognition, 13, 19–31.

- Müller, M. (2007). Information Retrieval for Music and Motion. Berlin: Springer.

Crowdsourcing-Literatur

- Causer, T. and Wallace, V. (2012). Building A Volunteer Community: Results and Findings from Transcribe Bentham. In Digital Humanities Quarterly, 6(2).

- Dunn, S. and Hedges, M. (2013). Crowd-sourcing as a Component of Humanities Research Infrastructures. In International Journal of Humanities and Arts Computing, 7(1-2), 147-169.

- Fornés, A., Lladós, J., Mas, J., Pujades, J. M. and Cabré, A. (2014). A Bimodal Crowdsourcing Platform for Demographic Historical Manuscripts. In Proceedings of the First International Conference on Digital Access to Textual Cultural Heritage, p. 103–108.

- Holley, R. (2010). Crowdsourcing: How and why should libraries do it? D-Lib Magazine, 16(3-4).

- Howe, J. (2006). The Rise of Crowdsourcing. Wired 14(6). Retrieved from http://archive.wired.com/wired/archive/14.06/crowds.html

- Ipeirotis, P. G. and Gabrilovich, E. (2014). Quizz: Targeted Crowdsourcing with a Billion (Potential) Users. In Proceedings of the 23rd International Conference on World Wide Web, p.143–154.

- Lee, T. Y., Dugan, C., Geyer, W., Ratchford, T., Rasmussen, J., Shami, N. S. and Lupushor, S. (2013). Experiments on motivational feedback for crowdsourced workers. In Proceedings of the 7th International Conference on Weblogs and Social Media (ICWSM), p. 341–350.

- Morschheuser, B., Hamari, J. and Koivisto, J. (2016). Gamification in crowdsourcing: A review. In Proceedings of the 49th Annual Hawaii International Conference on System Sciences, p. 4375–4384.

- Mühlberger, G., Zelger, J. and Sagmeister, D. (2014). User-Driven Correction of OCR Errors: Combining Crowdsourcing and Information Retrieval Technology. In Proceedings of the First International Conference on

- Oomen, J. and Aroyo, L. (2011). Crowdsourcing in the Cultural Heritage Domain: Opportunities and Challenges. In Proceedings of the 5th International Conference on Communities and Technologies, p. 138–149.

(II) Modellierung und formale Repräsentation

Encoding-Formate

- MIDI: https://www.midi.org/ (vgl. auch MidiJS)

- ABC: http://abcnotation.com/

- MusicXML: http://www.musicxml.com/ (vgl. auch MuseScore-Editor)

- MusicXML-Tutorial: http://www.musicxml.com/tutorial/hello-world/

- MEI: http://music-encoding.org/

- MEI Common Music Notation Ornaments: http://music-encoding.org/documentation/3.0.0/cmnOrnaments/

- MEI Vocal Text: http://music-encoding.org/documentation/3.0.0/lyricsDesc/

(III) Computergestützte Analyse

Music Information Retrieval-Definition (Downie, 2004)

Music Information Retrieval (MIR) is a multidisciplinary research endeavor that strives to develop innovative content-based searching schemes, novel interfaces, and evolving networked delivery mechanisms in an effort to make the world’s vast store of music accessible to all.

Überblick zu bestehenden MIR-Systemen im Web:

- Digital Archive of Finnish Folk Song Tunes: http://esavelmat.jyu.fi/index_en.html

- Dutch Song Database: http://www.liederenbank.nl/searchmusic/piano.php?&lan=en#x

- HymnQuest: http://hymnquest.com/

- Humdrum: http://www.musiccog.ohio-state.edu/Humdrum/

- Melody Catcher: http://melodycatcher.com/

- Musipedia: http://www.musipedia.org/

- PeachNote: http://www.peachnote.com/

- Probado: http://www.probado.de/

- RISM: https://opac.rism.info/

- Themefinder: http://www.themefinder.org/

Neben der Suche nach konkreten Melodien gibt es auch abstraktere Ebenen der Melodiesuche, bspw. die Suche nach Intervallfolgen oder nach Melodiekonturen im Parsons Code.

Für die Regensburger Liedblattsammlung wurde ein erster MIR-Prototyp implementiert, der als Melodic Similarity-Maß den Mongeau-Sankhoff-Algorithmus verwendet. Es handelt sich dabei um ein edit distance-basiertes Verfahren zur Bestimmung der Ähnlichkeit von zwei Melodiesequenzen. Um Verzerrungen bei der Editierdistanz zu vermeiden wird zudem ein Ngram-Ansatz umgesetzt, d.h. die Melodie-Query wird jeweils in bestimmten Teilsequenzen (ngrams) der Liedblätter gesucht (vgl. Burghardt & Lamm, 2017). Eine Demo zur Melodic Similarity-Suche in der Regensburger Liedblattsammlung ist verfügbar unter:

- http://masterarbeit.lukaslamm.com/search

Weitere Informationen:

- Burghardt, M., & Lamm, L. (2017). Entwicklung eines Music Information Retrieval-Tools zur Melodic Similarity-Analyse deutsch-sprachiger Volkslieder. In M. Eibl & M. Gaedke (Eds.), INFORMATIK 2017, Lecture Notes in Informatics (LNI), Gesellschaft für Informatik – Workshop „Musik trifft Informatik“ (pp. 15–27). Bonn: Springer.

Literatur MIR

- Casey, M., Veltkamp, R., Goto, M., Leman, M., Rhodes, C., & Slaney, M. (2008). Content-based music information retrieval: Current directions and future challenges. Proceedings of the IEEE, 96(4), 668-696.

- Downie, J. S. (2004). The Scientific Evaluation of Music Information Retrieval Systems: Foundations and Future. In Computer Music Journal 28(2), 12-23.

- Selfridge-Field, E. (1998). Conceptual and representational issues in melodic comparison. Computing in Musicology, 11, 3-64.

Literatur Melodic Similarity

- Berenzweig, A., Logan, B., Ellis, D. P. W., & Whitman, B. (2004). A Large-Scale Evaluation of Acoustic and Subjective Music-Similarity Measures. Computer Music Journal, 28, 63–76. http://doi.org/10.1162/014892604323112257

- Cahill, M., Cahill, M., Music, C., & Music, C. (2005). Melodic similarity algorithms – using similarity ratings for development and early evaluation. Star, 450–453.

- Hofmann-Engl, L. (2001). Towards a cognitive model of melodic similarity. Ismir, 44(0), 143–151.

- Grachten, M., Arcos, J. L., & Mántaras, R. L. De. (2004). Melodic Similarity: Looking for a Good Abstraction Level. Proceedings of the 5th International Society for Music Information Retrieval.

- Grachten, M., Arcos, J. L., and de Mántaras, R. L. (2002). A comparison of different approaches to melodic similarity. In Proceedings of the 2nd International Conference in Music and Artificial Intelligence (ICMAI).

- Miura, T., & Shioya, I. (2003). Similarity among melodies for music information retrieval. In Proceedings of the twelfth international conference on Information and knowledge management – CIKM ’03 (p. 61).

- Mongeau, M. and Sankoff, D. (1990). Comparison of Musical Sequences. In Computers and the Humanities, 24, 161–175.

- Müllensiefen, D., & Frieler, K. (2004). Optimizing Measures Of Melodic Similarity For The Exploration Of A Large Folk Song Database. 5th International Conference on Music Information Retrieval ISMIR 2004, 274–280.

- Müllensiefen, D., & Frieler, K. (2004). Melodic Similarity: Approaches and Applications. In Proceedings of the 8th International Conference on Music Perception & Cognition (pp. 283–289).

- Orio, N., & Rodá, A. (2009). A Measure of Melodic Similarity Based on a Graph Representation of the Music Structure. In Proceedings of the 10th International Society for Music Information Retrieval Conference (ISMIR 2009) (pp. 543–548).

- Typke, R., Wiering, F., & Veltkamp, R. C. (2005). A survey of music information retrieval systems. Transition, 153–160.

- Typke, R. (2007). Music Retrieval based on Melodic Similarity. Ph.D Thesis, (april 1973).

Schreibe einen Kommentar